¿Qué es Data Science?

Ciencia de Datos

Data Science o ciencia de datos es una disciplina científica centrada en el análisis de grandes fuentes de datos para extraer información, comprender la realidad y descubrir patrones con los que tomar decisiones.

Para conseguir convertir esa información no estructurada o estructurada en contenido de valor, el Data Science combina herramientas de la matemática, estadística y/o informática, para que, con todo ello, pueda llegar a cumplir su objetivo, la optimización de la toma de decisiones.

Puede que ya te estés preguntando de dónde surge su materia prima, y la respuesta está muy cerca: de ti.

Tú, como todo el mundo, generas información cada vez que consultas internet, te subes a un medio de transporte, compras en internet o consultas Instagram.

Pero además el mundo está cada vez más interconectado. Existen unos 20.0000 millones de sensores en todo el mundo, según datos de la consultora Gartner, y cada uno de ellos genera big data que se multiplica exponencialmente por la conexión de unos y otros en redes casi infinitas, es el Internet de las cosas (IoT).

Historia del Término Data Science

La terminología Data Science ha estado presente desde los últimos 30 años, sin embargo, no es hasta la década de los 70 cuando el término empieza a usarse para referirse a los métodos de procesamiento de datos. Fue en 2001, cuando la ciencia de datos se separa del big data, y se proclama como una disciplina independiente.

Diferencias entre Data Science y Big Data

Ya se ha analizado anteriormente la terminología Data Science, a continuación, para entender mejor ambas corrientes, vamos a definir Big Data; Este es el término con el que nos referimos a un gran número de datos, que pueden estar estructurados o no.

Para explicar el concepto se recurre a las 7V, No hay un consenso sobre cuántas “V” han de ser tomadas en consideración y de hecho la lista de estas se ha ido ampliando, pero podemos afirmar que las 7 «V» del Big Data más extendidas son:

- Volumen: Hablamos de datos o combinaciones de conjuntos de datos que no se pueden almacenar en un sistema tradicional.

- Variedad: Agrupa información de diferente tipo y fuente.

- Velocidad: Crece a gran velocidad, y lo que es más importante, obliga a procesarla con rapidez.

- Veracidad: Conocer la fiabilidad de los datos recogidos es fundamental para su correcta explotación.

- Valor: Una gran cuantía de datos cuenta, frecuentemente, cuenta con información de valor, cómo conseguir ese valor de manera eficiente, es un reto diario.

- Visualización: El objetivo es Convertir las grandes masas de datos en gráficos que muestre de forma dinámica y bien estructurado los valores más importantes.

- Variabilidad: El entorno de los macrodatos es muy cambiante, así que obliga a los modelos predictivos y a los trabajadores a estar actualizándose.

Principales diferencias entre ambos conceptos

- Big Data se caracteriza, cómo hemos citado anteriormente, por sus “7V”, mientras que Data Science cuenta con las técnicas necesarias para analizar dichos volúmenes de datos.

- La Inteligencia de Datos proporciona un increíble potencial de rendimiento. Sin embargo, es la ciencia de datos quién proporciona el lado teórico y experimental, además de proporcionar un proceso deductivo e inductivo.

- La ciencia de datos utiliza modelos inteligentes que aprenden de sí mismos, como el Machine Learning, junto con métodos estadísticos para entrenar a los ordenadores. En contraposición, el Big Data se encarga de la extracción de la información útil hallada en grandes fuentes de datos

Se puede afirmar entonces que, Data Science no existiría de no ser por el Big Data, dado que se desenvuelve dentro del ámbito. Sin embargo, el Big Data no tendría (u obtendría) el valor actual si no fuese gracias a los análisis y métodos usados por la ciencia de datos.

Conceptos Clave del Data Science

Como se ha mencionado anteriormente, el aprendizaje automático de las máquinas es posible gracias a ciertos algoritmos que identifican y aprenden de patrones.

Los principales algoritmos que se encargan de ello son:

Machine Learning

Qué es: El aprendizaje automático es una de las aplicaciones más interesantes de la inteligencia artificial. Crea sistemas capaces de identificar patrones complejos entre millones de datos, lo que consigue gracias a un algoritmo.

Para qué sirve: Los algoritmos de Machine Learning clasifican la información y son capaces de anticipar comportamientos aportando a la ciencia de datos esa capacidad predictiva tan importante: las organizaciones pueden actuar antes de que algo ocurra.

¿Alguna vez te ha llamado tu compañía telefónica para hacerte una oferta después de haber planteado una queja? Ocurre cuando sus sistemas de datos concluyen que se han producido una serie de hechos que a otros usuarios los ha llevado a darse de baja. Y para impedirlo, actúan, incluso antes de que pase.

Deep Learning

Qué es: El Deep Learning es uno de los diferentes sistemas para activar procesos de Machine Learning. Crea una red neuronal artificial estructurada por niveles jerárquicos. De este modo, el nivel más bajo aprende algo simple que envía a un segundo nivel jerárquico. Este segundo combina ese aprendizaje con otra información, convirtiéndola en algo más complejo, y así sucesivamente.

Para qué sirve: Además de para retar a los campeones del mundo de ajedrez como hace el programa Alpha Go de Google, es utilizado para descubrir un tipo de información entre millones de datos. Se utiliza diagnóstico médico, análisis de reacción de clientes frente a un producto, reconocimiento facial o identificación de emociones faciales, reconocimiento de voz, clasificación de vídeos, etc.

Las empresas más poderosas invierten cantidades ingentes en sistemas de Deep Learning que mejore la monitorización de mensajes en redes sociales e internet. Analizando esos mensajes, identifican nuevos grupos sociales de clientes, mejoran sus productos o combaten el fraude.

Text Mining

Qué es: Así se conoce al conocimiento y herramientas para analizar información textual. Este proceso que forma parte del Data Mining. Descubre una información que anteriormente no existía de modo explícito a través de la recuperación de datos, extracción de información y la Data Mining.

Para qué sirve: Para realizar búsquedas, descubrir relaciones o tendencias, clasificar de forma automática millones de documentos o elaborar resúmenes. Todo ello es valiosa materia prima para la ciencia de datos.

En los últimos años el Text Mining ha sido caballo de batalla en los procesos electorales de los países más avanzados del mundo. Se utiliza para identificar el sentimiento en las publicaciones en medios y redes sociales o medir el nivel de popularidad del candidato.

Data mining

Qué es: Conocida en español como minería de datos, su conocimiento y procedimiento permiten analizar grandes bases de datos de forma automatizada, identificando los patrones que explican el comportamiento de los datos. Estos patrones surgen utilizando herramientas de estadística y/o algoritmos con base en redes neuronales e inteligencia artificial.

Para qué sirve: Sus aportaciones a la ciencia de datos son muchas, pero quizá se puedan resumir en su capacidad para responder a preguntas con datos, o a preguntas que incluso las organizaciones no habían llegado a plantearse.

Por ejemplo, puede descubrir que un determinado alimento es comprado en el supermercado por los diabéticos por su escaso aporte de hidratos de carbono a su dieta. El descubrimiento le permitiría dirigir acciones comerciales específicas.

AI: Inteligencia Artificial

Qué es: ¿Pueden las máquinas tener un comportamiento humano? Acabamos con los conceptos clave del Data Science con este subcampo de la informática, llamado a cambiar el mundo. Crea programas y mecanismos capaces de responder con autonomía a información o estímulos en un comportamiento aparentemente inteligente o humano.

Para qué sirve: A la AI (Artificial Intelligence) se le atribuye una revolución infinita, entre otras cosas por su facilidad para integrarse en otras tecnologías. Su mayor aportación es no necesitar de la orden humana para actuar, capacidad que no todos ven con buenos ojos.

Desde la mejora del software fotográfico de tu smartphone a los sistemas de seguridad de los vehículos automáticos, como decimos, la AI añade una capa de eficiencia a casi cualquier actividad.

Salidas Profesionales tras formarse en Data Science

El analista de datos fue el puesto más demandado y mejor pagado en 2020 dentro del sector de Tecnologías de la Información española. Así lo afirmó el estudio Los más buscados, que la consultora de recursos humanos Adecco publica anualmente para analizar las salidas profesionales. Posiciones destacadas que repiten anualmente muchas de las diferentes profesiones relacionadas con el Big Data en España.

Además de facilidad para encontrar trabajo, este conocimiento permite a sus profesionales desarrollarse en diferentes áreas específicas. Repasamos las posiciones habituales dentro de la gran empresa, y cada vez más en la pyme, que de forma gradual incorpora a estos profesionales.

Data Analyst

Es un perfil orientado al análisis de data. Su rol principal es la Minería, obtención y/o recuperación de datos, así como su procesado, estudio avanzado y visualización. Es la fuerza de trabajo de la Data Science y el encargado de ejecutar la estrategia diseñada por el CDO.

Para ser el mejor: La destreza en el manejo de las herramientas de Business Intelligence que transforman la información en conocimiento es la principal habilidad que se reconoce a un buen Data Analyst.

Sueldo Medio en España del Perfil Data analyst:

28k/Año

Fuente: Glassdor Spain

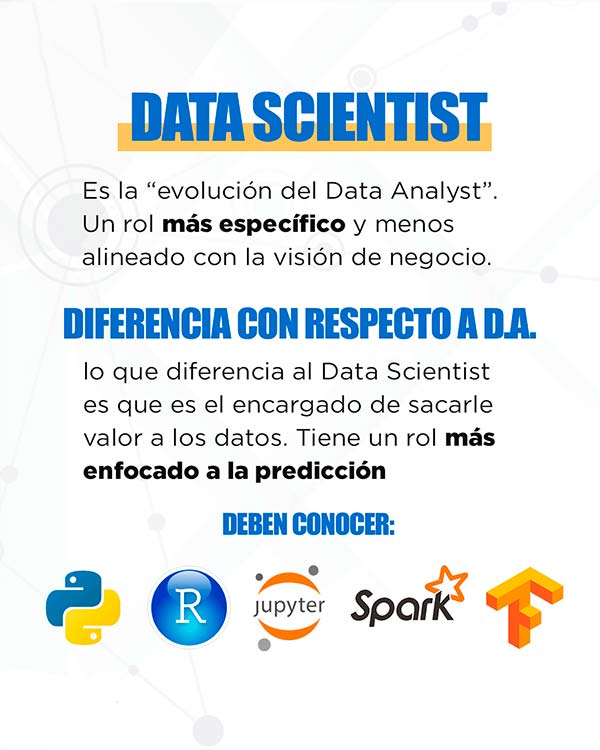

Data Scientist

Es un perfil orientado al análisis de data. Su rol principal es la Minería, obtención y/o recuperación de datos, así como su procesado, estudio avanzado y visualización. Es la fuerza de trabajo de la Data Science y el encargado de ejecutar la estrategia diseñada por el CDO.

Para ser el mejor: La destreza en el manejo de las herramientas de Business Intelligence que transforman la información en conocimiento es la principal habilidad que se reconoce a un buen Data Analyst.

Sueldo Medio en España del Perfil Data Scientist:

35k/Año

Fuente: Glassdor Spain

Data Engineer

Es el encargado de ejecutar el diseño del modelo elegido. Se encarga de preparar todo el ecosistema para que los demás puedan obtener sus datos limpios y preparados para su análisis. El rol principal de este perfil profesional se basa en el diseño, desarrollo, construcción, prueba y mantenimiento de los sistemas de procesamiento de datos.

Para ser el mejor: De nuevo su destreza en todas las herramientas de trabajo y su capacidad para ir incorporando nuevas herramientas y tecnologías marca la diferencia.

Sueldo Medio en España del Perfil Data Engineer:

40k/Año

Fuente: Glassdor Spain

Data Architect

Este perfil profesional se asemeja al Data Engineer, con la excepción de que poseen una visión más global y orientada a la integración, centralización y el mantenimiento de todas las fuentes de Datos. Es el encargado del diseño y la implementación de arquitecturas software en proyectos Big Data.

Para ser el mejor: Un buen Data Architect debe saber como tratar las database estructuradas y no estructuradas, lo que implica que debe tener conocimientos de SQL y NoSQL, y, para ello, tendrá que hacer uso de herramientas como MongoDB, Scala, Python…

Sueldo Medio en España del Perfil Data Architect:

48k/Año

Fuente: Glassdor Spain

Data Science: Los lenguajes de programación más usados

Python

Uno de los lenguajes de programación más populares entre los científicos de datos. Desde su creación en 1991, su desarrollo no ha sido ajeno a su condición de código abierto: es gratis.

Y tampoco su sencillez, incluso para aquellos que no han trabajado antes con otro lenguaje de programación, lo que es común cuando se empieza con la ciencia de datos. Y cuando hablamos de sencillez, nos referimos a su proceso de aprendizaje, no a sus posibilidades que son casi infinitas.

Cualidad posible gracias a su gran biblioteca de recursos, por eso se utiliza con fines muy diferentes como para sus aplicaciones en AI, Machine Learning y Big Data.

R (Lenguaje de Programación)

Heredero del software libre S, este lenguaje de programación nacido en 1993 tiene un enfoque claramente estadístico, de ahí su importancia en el análisis de datos. Y sí, también es gratis.

Permite trabajar con modelos estadísticos lineales y no lineales, análisis de series de tiempo, clasificaciones, etc. En conjunto ofrece un entorno poderoso para el estudio de datos.

De nuevo es un lenguaje que permite trabajar con funcionalidades diferentes, para lo que dispone de recursos y bibliotecas que permiten integrarse en otros lenguajes como Python. Otra de las alabanzas que recibe son su operativa para visualizar datos y para automatizar informes, dos funcionalidades que mejoran el día a día del profesional.

Conclusión

Como puedes ver, en múltiples ámbitos con objetivos muy diversos, el análisis de datos masivos es una herramienta fundamental para alcanzar las metas, con especial foco en el ámbito empresarial.

El Big Data y la Ciencia de Datos está en todas partes y la demanda de este tipo de profesionales no deja de crecer, siendo actualmente, más alta la demanda que la oferta.

Para formar parte de esta gran revolución tecnológica es una ventaja contar con formación técnica, pero debes saber que no es un conocimiento imprescindible. También es importante dominar el inglés, al menos en lectura para entender manuales técnicos.

Dada la demanda de profesionales, la oferta de formación cada vez es más extensa, por lo que en función de tus posibilidades debes encontrar el programa que más se adapte a tus ambiciones. La recomendación es que analices estos tres puntos:

Formación universitaria de prestigio. Nadie duda que la formación de postgrado universitaria es la más completa y reconocida. Más aún cuando se suma una institución del prestigio de la Universidad Complutense de Madrid (UCM), una de las instituciones educativas más reconocidas de Iberoamérica, con un alumnado fuertemente internacionalizado.

Formación práctica. Como en el aprendizaje de cualquier ciencia, en la de datos la práctica es fundamental para fijar el conocimiento teórico. Por esta razón el Máster de Big Data y Data Science de la UCM se plantea como un largo ejercicio, para lo que cuenta entre su profesorado con profesionales en activo o asesores de empresas líderes en Grandes masas de información como Google o BBVA.

Prácticas curriculares en empresas. ¿A que te resulta imposible imaginar un buen médico que no haya realizado prácticas con pacientes? Pues con el Data Science ocurre lo mismo. Por eso la UCM ofrece prácticas en empresas de primer nivel, y por eso sus alumnos encuentran trabajo rápidamente.